Файл robots.txt: создание, установка, применение

Далеко не все современные вебмастеры умеют работать с HTML-кодом. Многие даже не знают, как должны выглядеть функции, прописанные в ключевых файлах CMS. Внутренности вашего ресурса, такие как файл robots.txt, являются интеллектуальной собственностью, в которой владелец должен быть, как рыба в воде. Тонкая настройка сайта позволяет повысить его поисковые рейтинги, вывести в топ и успешно собирать трафик.

Файл robots.txt — один из основных элементов подгонки ресурса под требования поисковых систем. Он содержит техническую информацию и ограничивает доступ к ряду страниц поисковым роботам. Ведь далеко не каждая написанная страница должна непременно оказаться в выдаче. Раньше для создания файла robots txt был необходим доступ через FTP. Равитие CMS открыло возможность получить к нему доступ прямо через панель управления.

Для чего нужен файл robots.txt

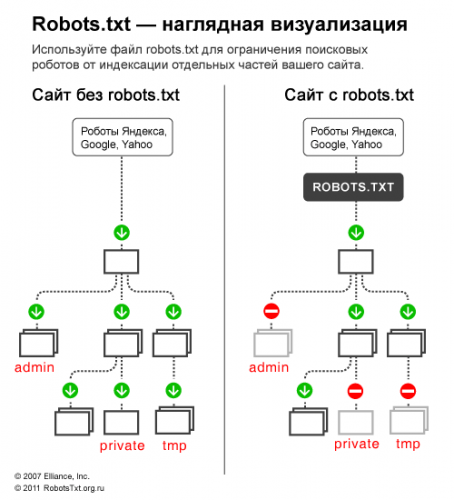

Этот файл содержит ряд рекомендаций, адресованных поисковым ботам. Он ограничивает их доступ к некоторым частям сайта. Из-за размещения этого файла в корневом каталоге, боты никак не смогут его пропустить. В результате, попадая на ваш ресурс, они сначала читают правила его обработки, а уже только после этого начинают проверку.

Таким образом, файл указывает поисковым роботам, какие директории сайта разрешены для индексирования, и какие этому процессу не подлежат.

Учитывая, что на процесс ранжирования наличие файла напрямую не влияет, много сайтов не содержат robots.txt. Но путь полного доступа нельзя считать техически правильным. Рассмотрим преимущества robots.txt, которые он дает ресурсу.

Можно запретить индексирование ресурса целиком или частично, ограничить круг поисковых роботов, которые будут иметь право на проведение индексирования. Приказывая robots.txt запретить все, вы сможете полностью изолировать ресурс на время ремонта или реконструкции.

Кроме того, файл роботс ограничивает доступ на ресурс всевозможных спам-роботов. Их основная цель — сканирование сайта на наличие электронных адресов, которые потом будут использоваться для рассылки спама. Не будем останавливаться на том, к чему это может привести — и так понятно.

Кроме того, файл роботс ограничивает доступ на ресурс всевозможных спам-роботов. Их основная цель — сканирование сайта на наличие электронных адресов, которые потом будут использоваться для рассылки спама. Не будем останавливаться на том, к чему это может привести — и так понятно.

От индексирования можно скрыть разделы сайта, предназначенные не для поисковых машин, а для определенного круга пользователей, разделы, содержащие приватную и прочую подобную информацию.

Как создать правильный robots.txt

Правильный robots легко написать вручную, не прибегая к помощи различных конструкторов. Процесс сводится к прописыванию нужных директив в обычном файле блокнота, который, после внесения всех данных, сохраняется под названием «robots». Вам остаётся только закачать его в корневую директорию собственного ресурса. Для одного сайта нужен только один такой файл. В нем можно прописать инструкции для ботов всех нужных поисковых систем. То есть, делать отдельный файл под каждый поисковик не понадобится. Полноценный robots.txt пример может выглядеть так:

Теперь поговорим о том, что должно находиться внутри robots.txt. Обязательно употребление двух директив: User-agent и Disallow. Первая определяет, какому боту адресовано данное послание. Вторая показывает, какую страницу или директорию ресурса запрещено индексировать.

Чтобы задать одинаковые правила для всех ботов, можно в директиве User-agent вместо названия прописать символ: * (звездочку).

Файл robots.txt в таком случае будет выглядеть следующим образом:

Как можно догадаться, /file.html — это название конкретного файла, индексация которого запрещена. /papka/ — название директории, на содержимое которой не будет распространятся индексация.

Как можно догадаться, /file.html — это название конкретного файла, индексация которого запрещена. /papka/ — название директории, на содержимое которой не будет распространятся индексация.

Если нужно снять ограничения и разрешить индексацию всех страниц, файл следует изменить так:

Особенности настройки robots.txt для Яндекс и Google

Особенности настройки robots.txt для Яндекс и Google

Файл robots.txt для Яндекса раньше должен был содержать обязательную директиву host. Это позволяло избежать проблем с индексированием зеркала ресурса или иных дублей его страниц.

Host — директива, которую понимал только бот Яндекса. Поэтому, при создании файла robots.txt одновременно для Яндекса, Гугла и других поисковых систем, следовало разделить директивы.

Host — директива, которую понимал только бот Яндекса. Поэтому, при создании файла robots.txt одновременно для Яндекса, Гугла и других поисковых систем, следовало разделить директивы.

Безвременная кончина этой директивы произошла в марте 2018. Так что больше её использовать не нужно.

Безвременная кончина этой директивы произошла в марте 2018. Так что больше её использовать не нужно.

Создание файла robots.txt Google ничем не отличается от процесса, описанного выше. В директиве User-agent нужно прописать название бота поисковика: Googlebot, Googlebot-Image (для ограничения индексаций изображений),Googlebot-Mobile (для версий сайтов, рассчитанных на мобильные приложения) и т.п.

Желательно указать в файле путь к карте сайта — директива robots.txt sitemap. Благодаря этому робот будет быстрее ориентироваться на страницах ресурса, что значительно ускорит процесс индексации.

Кстати, разработчики Гугл неоднократно напоминали веб-мастерам, что файл robots.txt не должен превышать по размерам 500 Кб. Это непременно приведет к ошибкам при индексации. Если создавать файл вручную, то «достичь» такого размера, конечно, нереально. Но вот некоторые CMS, автоматически формирующие содержание robots.txt, могут значительно его перегрузить.

Простое создание файла для любого поисковика

Если вы боитесь заниматься тонкой настройкой самостоятельно, её можно провести автоматически. Существуют конструкторы, собирающие подобные файлы без вашего участия. Они подходят людям, которые только начинают своё становление в качестве вебмастеров.

Как видно на изображении, настройка конструктора начинается с введения адреса сайта. Далее вы выбираете поисковые системы, с которыми планируете работать. Если вам не важна выдача той или иной поисковой системы, то нет необходимости создавать под неё настройки. Теперь переходите к указанию папок и файлов, доступ к которым планируете ограничить. В данном примере вы сможете указать адрес карты и зеркала вашего ресурса.

Robots.txt generator будет заполнять форму по мере наполнения конструктора. Всё, что в дальнейшем от вас потребуется — это скопировать полученный текст в txt-файл. Не забудьте присвоить ему название robots.

Как проверить эффективность файла robots.txt

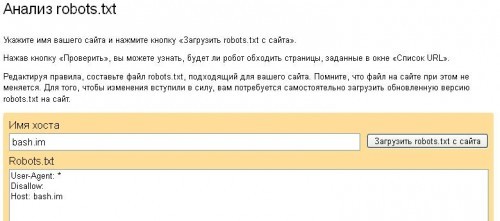

Для того, чтобы проанализировать действие файла в Яндексе, следует перейти на соответствующую страницу в разделе Яндекс.Вебмастер. В диалоговом окне укажите имя сайта и нажмите кнопку «загрузить».

Система проанализирует файл robots.txt проверка покажет, будет ли поисковый робот обходить страницы, запрещенные к индексации. Если возникли проблемы, директивы можно отредактировать и проверить прямо в диалоговом окне. Правда после этого вам придётся скопировать отредактированный текст и вставить в свой файл robots.txt в корневом каталоге.

Аналогичную услугу предоставляет сервис «Инструменты для веб-мастеров» от поисковика Google.

Создание robots.txt для WordPress , Joomla и Ucoz

Различные CMS, получившие широкую популярность на просторах Рунета, предлагают пользователям свои версии файлов robots.txt. Некоторые из них не имеют таких файлов вовсе. Зачастую эти файлы либо слишком универсальны и не учитывают особенностей ресурса пользователя, либо имеют ряд существенных недостатков.

Опытный специалист может вручную исправить положение (при недостатке знаний так лучше не делать). Если вы боитесь копаться во внутренностях сайта, воспользуйтесь услугами коллег. Подобные манипуляции, при знании дела, занимают всего пару минут времени. Например, robots.txt WordPress может выглядеть таким образом:

Файл robots.txt для Ucoz предоставляется автоматически. Он имеет оптимальные настройки. Единственный его недостаток — система создаст файл, спустя примерно месяц, после конструирования ресурса. Если неохота ждать, можно написать файл самостоятельно. Выглядеть он будет так:

Файл robots.txt для Ucoz предоставляется автоматически. Он имеет оптимальные настройки. Единственный его недостаток — система создаст файл, спустя примерно месяц, после конструирования ресурса. Если неохота ждать, можно написать файл самостоятельно. Выглядеть он будет так:

Joomla позволяет нескольким URL ссылаться на одну и ту же страницу. Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

Joomla позволяет нескольким URL ссылаться на одну и ту же страницу. Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

В последних двух строчках, как несложно догадаться, нужно прописать данные собственного ресурса.

Заключение

Есть ряд навыков, обязательных для освоения любым вебмастером. И самостоятельная настройка и ведение сайта — один из них. Начинающие сайтостроители могут таких дров наломать во время отладки ресурса, что потом не разгребёшь. Если вы не хотите терять потенциальную аудиторию и позиции в выдаче из-за структуры сайта, подходите к процессу её настройка основательно и ответственно.